原标题:【谷歌Facebook称霸AI全息战图】一图看懂全球AI巨头实验室布局

【新智元导读】随着阿里AI实验室揭开神秘面纱,目前BAT的AI实验室都已经公开。作为工业界人工智能研究的重要基地,人工智能实验室对企业来说意味着,扮演了什么角色?以谷歌和Facebook为例,本文用2张信息图示,非常清晰地勾画两家最 AI-first 的企业内部围绕 AI 的组织架构,包括实验室或部门设计,研究领域,应用场景范围等。我们还全面地盘点了这两家公司AI实验室中的华人研究员,看看都有谁。

无论你属于哪个公司,都可以从这两个范例得到启发,设计自己的 AI-first 组织。

一个 AI-first 的组织是很复杂的。它有多个连接层,多个集中化(研究中心)或分散化(确保每个团队充分的利用AI的可能性)的部门。这在专门技术人员的分布上是显而易见的:从AI科学家到产品经理都具有广泛的AI技能。

AI-first 的组织体现在每个方面:不仅是团队,还有内部软件平台,开源项目和最终提供的服务。

在 AI-first 的组织中,技术能力最强的专家不仅要创造突破性的研究项目或开发新技术,还要领导团队内部的培训工作。AI-first 的组织本质上是灵活的:他们的目标是进行更多的利用AI的实验,同时加快部署的速度和提高拓展成功案例的能力。

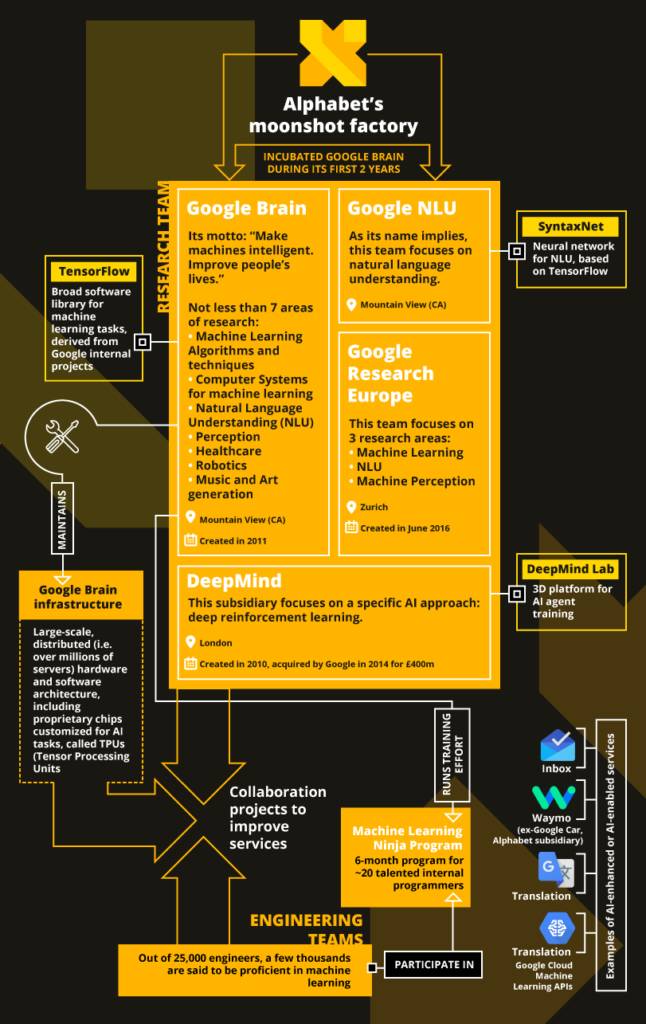

谷歌大脑,创建于2011年,遵循的这样一条简单的原理:人工的”神经网络“能通过试错,来熟知世界,正如婴儿所做的那样,这将为机器带来一些像人一样的灵活性。其目标是:创造更智能的软件和系统,从而改善人的生活。

Jeff Dean 的头衔是高级研究员(senior fellow),实际上确实谷歌大脑的大脑。Dean 身材消瘦,瘦长的脸上眼窝深陷,透露着一股热诚。作为医学人类学家和公共卫生流行病学家的儿子,Dean 从小周游世界——美国的明尼苏达州、夏威夷、波士顿、阿肯色州,此外日内瓦、乌干达、索马里、亚特兰大等地,他在高中和大学期间写的软件被世界卫生组织拿去用。他 25 岁左右,也就是 1999 年以来就一直在 Google 工作,从那时起,他在几乎参与了开发所有重点项目的核心软件系统。关于他的种种传说 Jeff Dean Facts 在公司里成了一种文化。

2011 年初的一天,Dean 遇到了吴恩达,那时候吴恩达还是斯坦福计算机科学教授,是谷歌的顾问。吴恩达告诉了 Dean 他自己帮助在谷歌内部建立的一个项目——Project Marvin(以著名的 AI 先驱马文·明斯基命名),用于研究“神经网络”,模仿人类大脑结构的数字网格。Dean 1990 年在明尼苏达大学读本科时也做过类似技术的原始版,当时那一段时间神经网络还算流行。现在,在过去的五年中,从事神经网络研究的学者数量慢慢的开始再次增长,从很少几个到几十个。吴恩达告诉 Dean,由谷歌 X 实验室支持的 Project Marvin 已经取得了一些好的结果。

Dean 对这一个项目很感兴趣,于是拿出他 20% 的时间参与进来——每个 Google 员工都要拿出 20% 的时间从事自己核心业务以外的工作。很快,Dean 建议吴恩达邀请有神经科学背景的同事Greg Corrado 加入,那时候 Corrado 听说过人工神经网络,但了解不多。后来,吴恩达最好的一个研究生 Quoc Le 也作为项目的第一个实习生加入了团队。到那时,一些 Google 工程师开始用 Google Brain 称呼 Project Marvin。

Dean、Corrado 和吴恩达(兼职)开始合作,立即就取得了进展。他们从最近的理论大纲以及自20世纪80年代和90年代的想法中吸取灵感,并利用谷歌无与伦比的数据储备和庞大的计算基础设施。他们将大量“标记”数据输入网络,计算机的输出一直在改进,愈发接近现实。

Google Brain 成立的第二年,Geoffrey Hinton 加入了,而吴恩达则离开。Hinton 当时只想离开多伦多大学在谷歌待三个月,所以由于种种原因,谷歌不得不被聘他为实习生。

2016年年底,谷歌大脑负责人Jeff Dean在曾公开过一份谷歌大脑的”年度总结”,他在总结里写道:

我们还有许多其他论文在自然语言处理(ACL,CoNNL),语音(ICASSP),视觉(CVPR),机器人(ISER)和计算机系统(OSDI)领域会议被收录。团队还向CLR 2017年提交了34篇论文,这是一个最前沿的深度学习研究顶级会议。

在上面的信息图表上,我们大家可以看到,从功能上看,谷歌大脑的基础设施包括,大规模、分布式(数百万台服务器)的硬件和软件架构,其中为AI任务定制的专有芯片,即TPU(张量处理器)也属于谷歌大脑。

另外,著名的开源框架TensorFlow也是来自谷歌大脑。TensorFlow 是一个用于机器学习任务的开源软件库,源自谷歌内部的项目。从2015年开源以来,TensorFlow 已经成为开源社区上最受欢迎的深度学习软件框架。

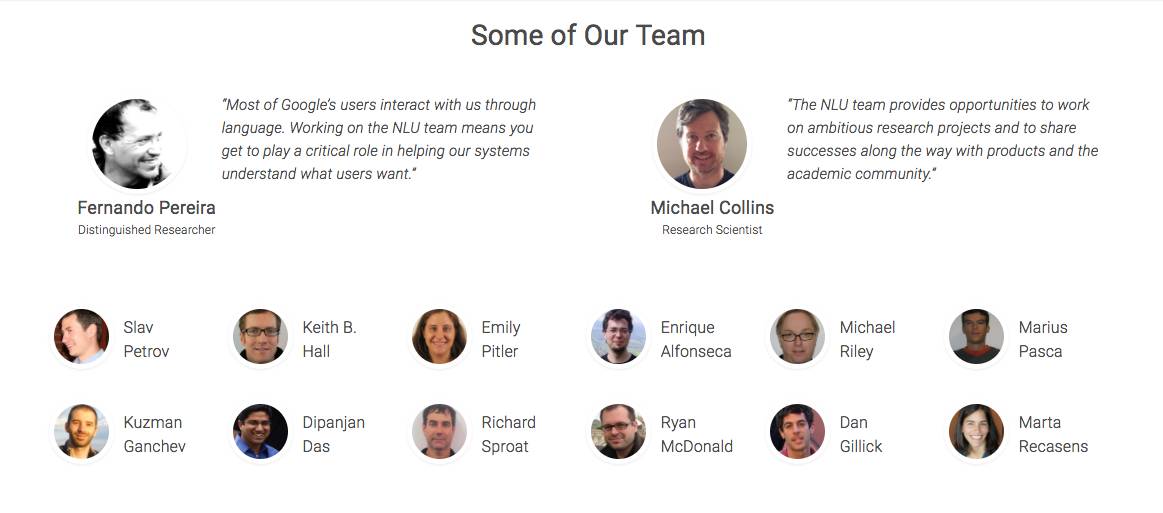

顾名思义,Google NLU 是专注于自然语言理解的团队。但是比较意外的是,这个团队与谷歌大脑是并列存在的关系。足以看到自然语言理解对于谷歌整个公司的重要性。在其官网上用大字写着这样一句话:

理解语言是机器学习的圣杯。——谷歌资深副总裁 John Giannandrea

团队包括多个研究小组,致力于一系列自然语言理解(NLU)项目。与谷歌内部其他团队紧密合作,利用有效的算法,神经网络,图模型和概率模型来帮助产品开发。在这样的过程中,Google NLU团队能够与用户进行沟通,找到用户问题的答案,为开发者分析app商店的评论等。

研究人员是传统自然语言处理和机器学习的专家,并能将方法论研究与应用科学相结合。所有的NLU工程师都参与长期的研究工作,并推动技术的即时应用。系统也受益于谷歌的语言学家,他们提供有价值的标签数据,并有助于国际化。

Google NLU团队的最新研究兴趣包括句法,语篇,对话,多语言建模,情绪分析,问答,概述,以及使用有标记和未标记的数据,最先进的模型和间接监督来构建更好的学习系统。

谷歌NLU目前公开的最重要的成果就是被称为“世界准确度最高的自然语言解析器SyntaxNet”。这是一个基于TensorFlow的自然语言理解神经网络。谷歌在该平台上训练的模型的语言理解准确率超过90%。

SyntaxNet是一个框架,即学术圈所指的SyntacticParser,他是许多NLU系统中的关键组件。在这个系统中输入一个句子,他会自动给句子中的每一个单词打上POS(part-of-Speech)标签,用来描述这些词的句法功能,并在依存句法树中呈现。这些句法关系直接涉及句子的潜在含义。

2016年10月,谷歌宣布,将SyntaxNet开源。谷歌资深研究科学家Slav Petrov在Google Research的博客上写到:在谷歌,我们花费了大量的时间在思考,计算机系统如何才能阅读和理解人类语言,以一种更加智能的方式处理这些语言?今天,我们激动地跟大家分享我们的研究,向更广阔的人群发布SyntaxNet。这是一个在TensoFlow中运行的开源神经网络框架,提供自然语言理解系统基础。我们所公开的包含了所有用你自己的数据训练新的SyntaxNet模型所需要的代码,以及Paesey McParseface——我们已经训练好的,可用于分析英语文本的模型。

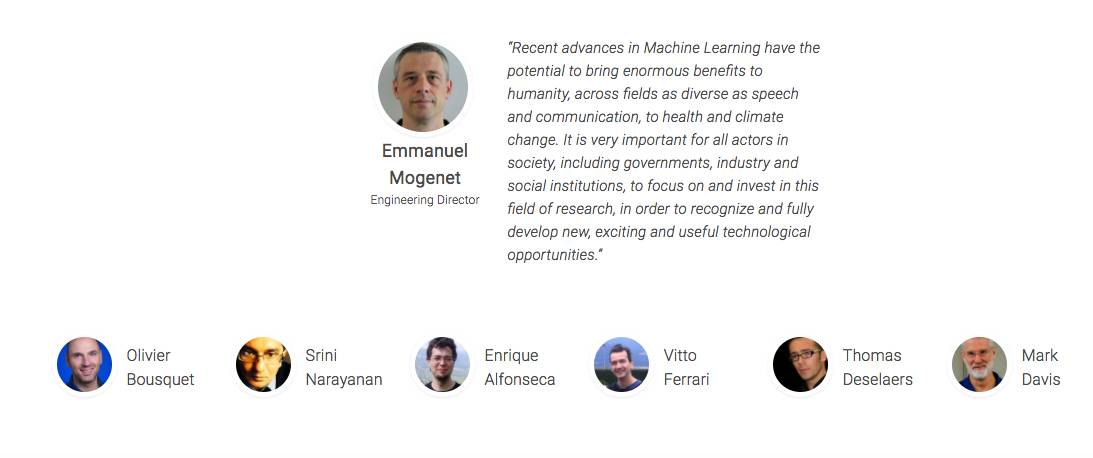

Google Research Europe 是Google在苏黎世办公室建立的研究团队,软件工程师和专门从事机器学习的研究人员在这里开发产品并进行研究。致力于解决一系列计算机科学的挑战,主要集中在以下几个方面:

机器学习:深入理解深度学习的理论基础,目标是加快构建和部署端到端学习系统的速度。

自然语言理解(NLU):和Google Assistant团队合作,Google Assistant是十分依赖对自然语言进行语义理解,以及使用自然语言提供答案的能力的产品。

机器感知:使用计算机视觉技术和机器学习来获取对图像和视频的语义理解,并最终构建“常识”知识。

数据压缩:数据压缩团队构建,开源,并帮助有损和无损压缩方法的标准化,以提高空间利用率,加快网页加载速度。

DeepMind 是谷歌的子公司,专注于一个具体的AI方法:深度强化学习。总部位于伦敦,2010年成立,在2014年被谷歌以4亿英镑收购。被收购后,DeepMind的运行保持独立。

关于DeepMind,最知名的项目莫过于AlphaGo——击败了世界冠军李世石和柯洁的AlphaGo被视为人工智能历史上的里程碑,也被认为是新一轮人工智能的标志性事件。

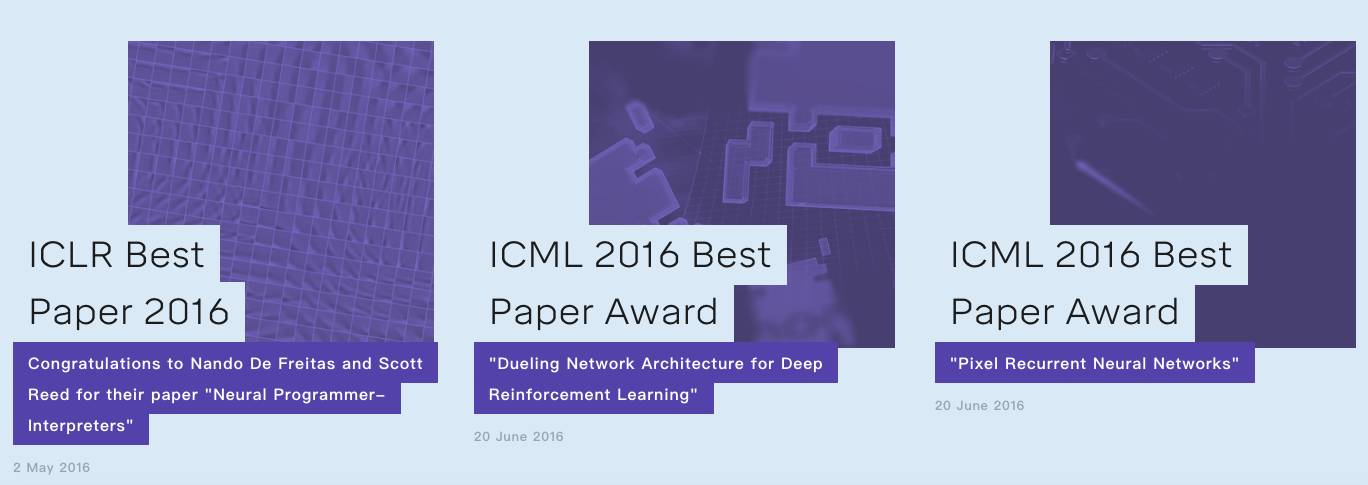

DeepMind 科研实力非常强,以下是2016年DeepMind拿下的顶会最佳论文:

7月5日,DeepMind表示,将在加拿大埃德蒙顿开设第一家AI研究中心,该研究中心将与加拿大阿尔伯塔大学紧密合作。这是DeepMind在英国之外的地方开设的首个AI研究实验室。该实验室已经聘请三名阿尔伯塔大学的教授作为负责人,分别是 Rich Sutton,Michael Bowling 和 Patrick Pilarski,三人将仍保持在大学的职务。其中 Rich Sutton 是强化学习领域的先驱,并且从2010年起一直担任 DeepMind 顾问。

从谷歌内部团队挑选有天赋的约20名程序员,为期6个月的人工智能人才培养项目。与谷歌大脑有合作关系。

Google的利用AI的服务包括:谷歌云机器学习API、翻译、Waymo(前谷歌无人车部门,现在是Alphabet子公司)、Inbox 等

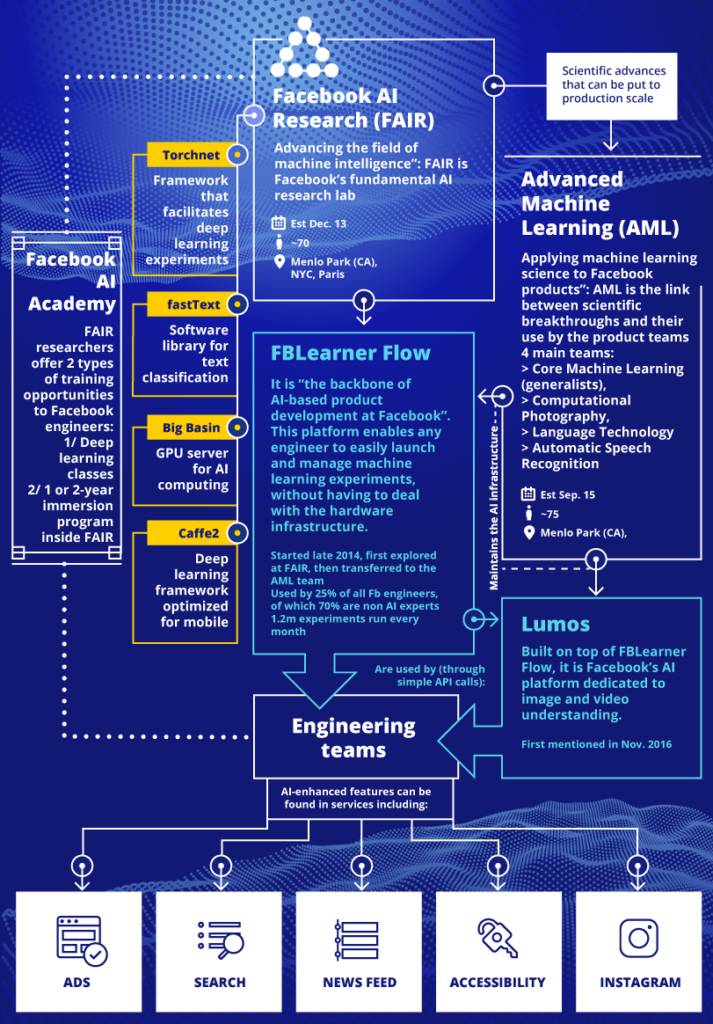

Facebook的人工智能架构与谷歌的有很大的不一样。主要有两个核心部门:

著名的AI 研究院(FAIR)和工程团队。AI 研究院背后,还有一个组织:应用机器学习部门。而工程团队则直接负责对接到Facebook的核心功能,比如广告、搜索、新闻流、密钥和Instagram。

Facebook 人工智能实验室和应用机器学习(Applied Machnie Learning)有着共生的关系。Facebook 部署的很多人工智能产品,都是在 AML、FAIR 和产品部门的合作下完成的。

根据FAIR的负责人LeCun 介绍,FAIR 和 AML 都会做研究以及工程驱动的开发。我会说 FAIR 把 75% 的精力投入到研究,25% 的精力放在了工程上。而 AML 也许是 75% 的工程,以及 25% 放在了研究上。FAIR 和 AML 的分界线是特意模糊的。有些人在两个组织里脚踩两只船。他们是 FAIR 年轻的工程师们,我们把他们称为“研究工程师”,他们和研究科学家一起做研究项目。而当这些项目从研究阶段到开发时,有些研究工程师会选择跟随他们的项目到开花结果,这样就会进入到 AML 团队。这是非常好的方法,把最先进的技术从研究状态散播出去。

在官网上能够正常的看到,Facebook与AI相关的研究包括:应用机器学习部门、计算机视觉、人工智能实验室、人机交互和自然语言处理5大分支。

FAIR 是 Facebook 的AI基础研究实验室,目标是推动机器智能领域的进步。这是Facebook 人工智能技术的核心部门。

查阅官网,新智元了解到,FAIR 目前总人数为76人,其中华人学者约10名,其中包括较为知名的何恺明和田渊栋。

工程团队则直接负责对接到Facebook的核心功能,比如广告、搜索、新闻流、密钥和Instagram。

FBLearner Flow是“Facebook研发基于AI的产品的支柱”。这个平台能帮助任何工程师轻松地开启和管理机器学习实验,而无需处理硬件基础架构。

将机器学习应用到 Facebook 的产品:AML是科学突破与产品使用连接起来的部门。

FAIR 是 Facebook 的AI实验室,FAIR 的研究人员为 Facebook 的工程师们提供两种类型的 AI 培训:1. 深度学习课程;2. 在FAIR 内部参与1~2年沉浸式项目。

Lumos 是构建在 FBLearnerFlow 之上,专用语图像和视频理解的AI平台。首次披露实在2016年11月。

谷歌和Facebook都是国际领先的互联网巨头,在AI的研究和产品应用上也走在了前列。但是具体看来,也能够正常的看到,谷歌的AI的研究部门设置和部署更多以技术为核心,但是Facebook更看重具体AI 技术与实际产品应用匹配度。这与两家公司所关注的方向和地位有着紧密的关系。

目前,国内众多互联网公司,包括BAT在内,都设置了自己的AI实验室。以上的挖掘,希望能为大家提供一个参考。